pytorch乘法介绍!pytorch中的matmul与mm,bmm区别说明

2021-08-18 10:01:41

浏览数 (6855)

在线性代数中,矩阵是可以相乘的,在pytorch中矩阵也可以相乘。今天小编就带来一篇pytorch乘法介绍,里面介绍了pytorch中的matmul与mm和bmm的区别说明。让我们来了解pytorch中是怎么实现矩阵乘法的吧。

先看下官网上对这三个函数的介绍。

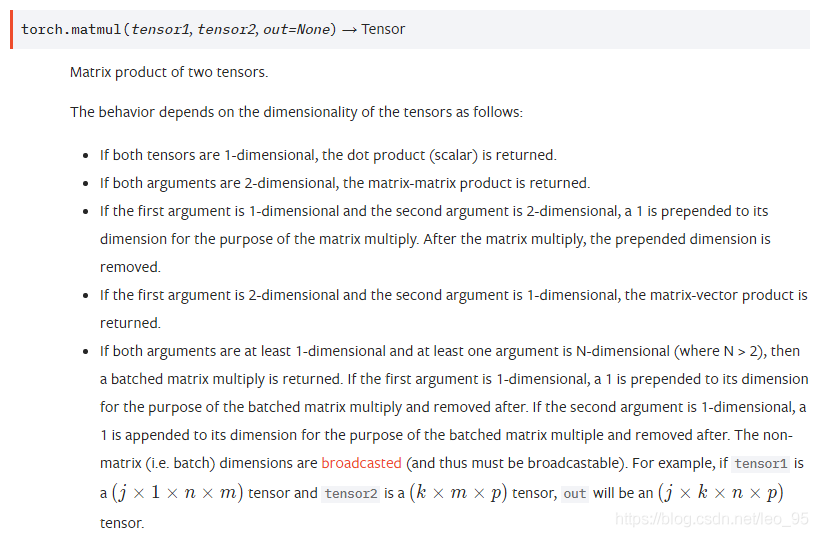

matmul

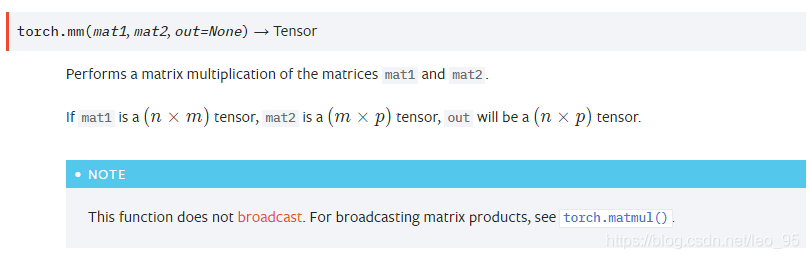

mm

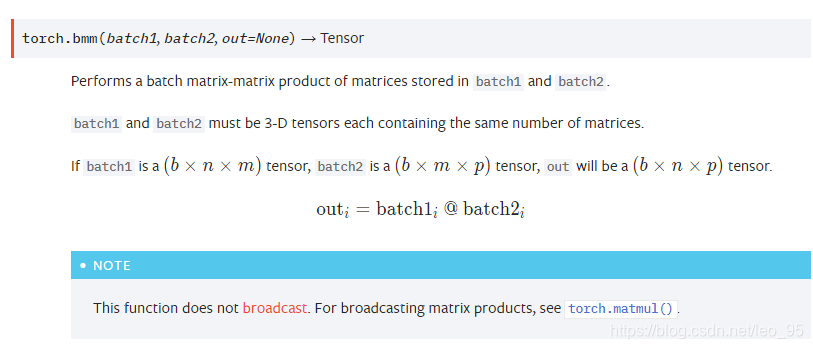

bmm

顾名思义, 就是两个batch矩阵乘法.

结论

从官方文档可以看出

1、mm只能进行矩阵乘法,也就是输入的两个tensor维度只能是( n × m ) (n imes m)(n×m)和( m × p ) (m imes p)(m×p)

2、bmm是两个三维张量相乘, 两个输入tensor维度是( b × n × m ) (b imes n imes m)(b×n×m)和( b × m × p ) (b imes m imes p)(b×m×p), 第一维b代表batch size,输出为( b × n × p ) (b imes n imes p)(b×n×p)

3、matmul可以进行张量乘法, 输入可以是高维.

补充:torch中的几种乘法。torch.mm, torch.mul, torch.matmul

一、点乘

点乘都是broadcast的,可以用torch.mul(a, b)实现,也可以直接用*实现。

>>> a = torch.ones(3,4)

>>> a

tensor([[1., 1., 1., 1.],

[1., 1., 1., 1.],

[1., 1., 1., 1.]])

>>> b = torch.Tensor([1,2,3]).reshape((3,1))

>>> b

tensor([[1.],

[2.],

[3.]])

>>> torch.mul(a, b)

tensor([[1., 1., 1., 1.],

[2., 2., 2., 2.],

[3., 3., 3., 3.]])当a, b维度不一致时,会自动填充到相同维度相点乘。

二、矩阵乘

矩阵相乘有torch.mm和torch.matmul两个函数。其中前一个是针对二维矩阵,后一个是高维。当torch.mm用于大于二维时将报错。

>>> a = torch.ones(3,4)

>>> b = torch.ones(4,2)

>>> torch.mm(a, b)

tensor([[4., 4.],

[4., 4.],

[4., 4.]])>>> a = torch.ones(3,4)

>>> b = torch.ones(5,4,2)

>>> torch.matmul(a, b).shape

torch.Size([5, 3, 2])>>> a = torch.ones(5,4,2)

>>> b = torch.ones(5,2,3)

>>> torch.matmul(a, b).shape

torch.Size([5, 4, 3])>>> a = torch.ones(5,4,2)

>>> b = torch.ones(5,2,3)

>>> torch.matmul(b, a).shape

报错。

以上就是pytorch乘法介绍的全部内容,希望能给大家一个参考,也希望大家多多支持W3Cschool。如有错误或未考虑完全的地方,望不吝赐教。